En el vasto universo del aprendizaje automático, la reducción de dimensionalidad emerge como una técnica crucial para simplificar conjuntos de datos complejos y mejorar el rendimiento de los modelos. Entre las diversas herramientas disponibles para este propósito, los Autoencoders destacan por su capacidad de aprender representaciones comprimidas y significativas de los datos de manera no supervisada. En este artículo, exploraremos en profundidad los Autoencoders, desde su arquitectura fundamental hasta sus aplicaciones prácticas en la industria. Descubriremos cómo funcionan, cómo se entrenan y cómo puedes implementarlos utilizando bibliotecas populares como Keras.

¿Qué son los Autoencoders?

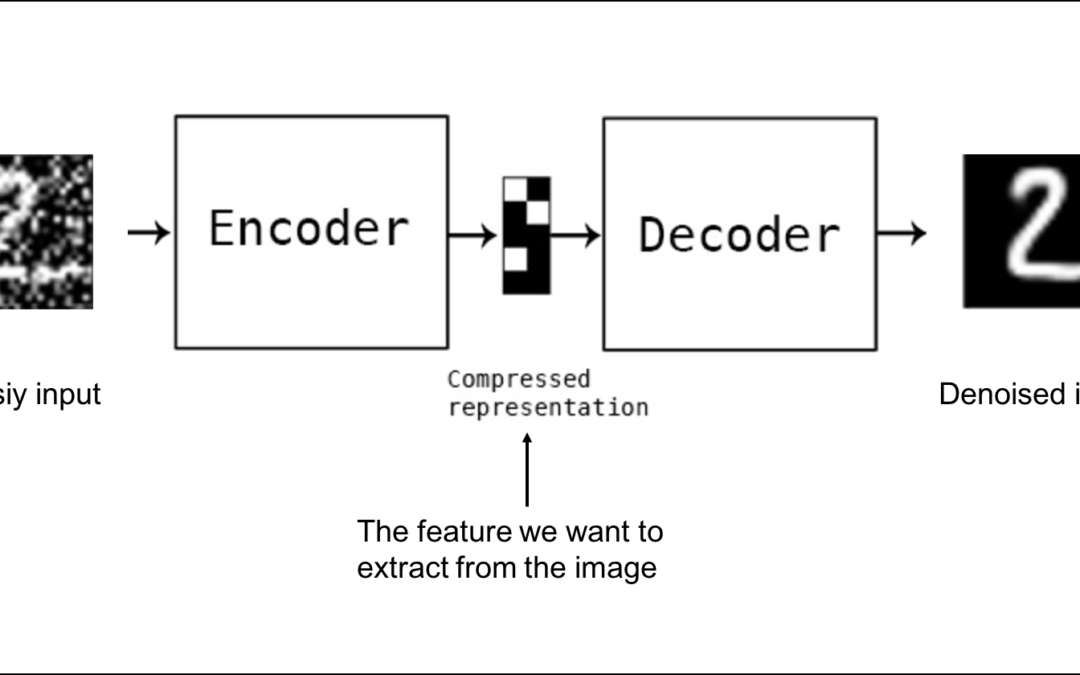

Los Autoencoders son redes neuronales diseñadas para aprender representaciones comprimidas y codificadas de los datos de entrada. Su objetivo principal es reconstruir la entrada original a partir de esta representación comprimida. En esencia, un Autoencoder consta de dos partes principales:

- Encoder: Toma la entrada y la comprime en una representación de menor dimensión, conocida como el código o representación latente.

- Decoder: Toma el código y lo reconstruye para crear una salida que sea lo más similar posible a la entrada original.

La arquitectura típica de un Autoencoder se puede representar de la siguiente manera:

Entrada -> Encoder -> Código -> Decoder -> SalidaEl proceso de compresión y reconstrucción obliga al Autoencoder a aprender las características más importantes de los datos, descartando el ruido y la información redundante. Esto hace que los Autoencoders sean especialmente útiles para la reducción de dimensionalidad, la eliminación de ruido y la detección de anomalías.

Tipos de Autoencoders:

- Autoencoders Tradicionales (Undercomplete Autoencoders): El código tiene una dimensión menor que la entrada, lo que obliga a la red a aprender una representación comprimida.

- Autoencoders Esparcidos (Sparse Autoencoders): Se penaliza la activación de las neuronas en la capa oculta para fomentar representaciones dispersas y más significativas.

- Autoencoders Contractivos (Contractive Autoencoders): Se penaliza la sensibilidad de la representación latente a pequeñas variaciones en la entrada, haciendo la representación más robusta.

- Autoencoders Variacionales (Variational Autoencoders – VAEs): Producen una distribución de probabilidad sobre el espacio latente, lo que permite generar nuevos datos similares a los datos de entrenamiento.

- Autoencoders Denoising: Se entrenan para reconstruir la entrada original a partir de una versión corrupta (con ruido), haciéndolos robustos al ruido en los datos.

Cómo se entrenan

El entrenamiento de un Autoencoder implica ajustar los pesos de la red neuronal para minimizar la diferencia entre la entrada original y la salida reconstruida. Este proceso se realiza utilizando un algoritmo de optimización, como el descenso de gradiente, y una función de pérdida que mide la calidad de la reconstrucción.

Función de Pérdida:

La función de pérdida más común para los Autoencoders es el error cuadrático medio (MSE), que mide la diferencia al cuadrado entre cada valor de la entrada y su correspondiente valor en la salida reconstruida:

MSE = (1/n) * Σ(xᵢ - x'ᵢ)²

Donde:

nes el número de elementos en la entrada.xᵢes el valor del i-ésimo elemento en la entrada original.x'ᵢes el valor del i-ésimo elemento en la salida reconstruida.

Otras funciones de pérdida comunes incluyen la entropía cruzada (para datos binarios) y la divergencia de Kullback-Leibler (KL) (para Autoencoders Variacionales).

Proceso de Entrenamiento:

El proceso de entrenamiento típicamente sigue estos pasos:

- Inicialización de pesos: Los pesos de la red neuronal se inicializan aleatoriamente.

- Paso hacia adelante (Forward pass): La entrada se pasa a través del Encoder para obtener el código, y luego a través del Decoder para obtener la salida reconstruida.

- Cálculo de la pérdida: Se calcula la función de pérdida comparando la entrada original con la salida reconstruida.

- Retropropagación (Backpropagation): Se calcula el gradiente de la función de pérdida con respecto a los pesos de la red.

- Actualización de pesos: Los pesos se actualizan utilizando el algoritmo de optimización (e.g., descenso de gradiente) para minimizar la función de pérdida.

- Repetir pasos 2-5: Se repiten los pasos anteriores durante un número determinado de épocas o hasta que la función de pérdida converja a un valor mínimo.

Consideraciones de Entrenamiento:

- Normalización de datos: Es importante normalizar los datos de entrada para asegurar que todas las características tengan un rango similar de valores.

- Tamaño del código: El tamaño del código (la dimensión de la representación latente) afecta la capacidad del Autoencoder para comprimir los datos. Un código demasiado pequeño puede resultar en una pérdida significativa de información, mientras que un código demasiado grande puede no lograr una reducción de dimensionalidad efectiva.

- Regularización: Técnicas de regularización, como la penalización L1 o L2, pueden ayudar a prevenir el sobreajuste y mejorar la generalización del Autoencoder.

Ejemplo con Keras

A continuación, se muestra un ejemplo de cómo implementar un Autoencoder simple utilizando Keras:

import keras

from keras import layers

# Definir la dimensión del código

encoding_dim = 32 # Comprimir las entradas a la dimensión 32

# Definir la capa de entrada

input_img = keras.Input(shape=(784,))

# Encoder

encoded = layers.Dense(encoding_dim, activation='relu')(input_img)

# Decoder

decoded = layers.Dense(784, activation='sigmoid')(encoded)

# Definir el Autoencoder

autoencoder = keras.Model(input_img, decoded)

# Configurar el optimizador y la función de pérdida

autoencoder.compile(optimizer='adam', loss='binary_crossentropy')

# Preparar los datos de entrenamiento

from keras.datasets import mnist

import numpy as np

(x_train, _), (x_test, _) = mnist.load_data()

# Normalizar los datos

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

x_train = x_train.reshape((len(x_train), np.prod(x_train.shape[1:])))

x_test = x_test.reshape((len(x_test), np.prod(x_test.shape[1:])))

# Entrenar el Autoencoder

autoencoder.fit(x_train, x_train, epochs=50, batch_size=256, shuffle=True, validation_data=(x_test, x_test))

En este ejemplo:

- Definimos un Autoencoder con una capa de entrada de dimensión 784 (correspondiente a las imágenes MNIST aplanadas), una capa de código de dimensión 32 y una capa de salida de dimensión 784.

- Utilizamos la función de activación ReLU en la capa del Encoder y la función de activación sigmoide en la capa del Decoder.

- Compilamos el Autoencoder utilizando el optimizador Adam y la función de pérdida binary_crossentropy (apropiada para la reconstrucción de datos binarios).

- Entrenamos el Autoencoder utilizando el conjunto de datos MNIST.

Extracción del Encoder:

Para utilizar la salida del encoder como una representación comprimida de los datos, podemos crear un nuevo modelo que solo contenga la parte del encoder:

# Crear el modelo del Encoder

encoder = keras.Model(input_img, encoded)

# Codificar las imágenes de prueba

encoded_imgs = encoder.predict(x_test)

Ahora, encoded_imgs contendrá la representación comprimida de las imágenes de prueba.

Aplicaciones en la industria

Los Autoencoders han encontrado numerosas aplicaciones en diversas industrias:

- Reducción de Dimensionalidad: En áreas como el procesamiento de imágenes y el análisis de datos genómicos, los Autoencoders se utilizan para reducir la dimensionalidad de los datos, lo que facilita la visualización, el almacenamiento y el procesamiento.

- Detección de Anomalías: Los Autoencoders pueden entrenarse para reconstruir datos normales. Si se les presenta un dato anómalo, la reconstrucción será de baja calidad, lo que permite identificar la anomalía. Esto se utiliza en la detección de fraudes, el mantenimiento predictivo y la seguridad cibernética.

- Eliminación de Ruido: Los Autoencoders Denoising se utilizan para eliminar el ruido de las imágenes, el audio y otros tipos de datos.

- Generación de Datos: Los Autoencoders Variacionales (VAEs) pueden generar nuevos datos similares a los datos de entrenamiento. Esto se utiliza en la generación de imágenes, la creación de música y el diseño de fármacos.

- Compresión de Datos: Si bien no es su uso principal, los Autoencoders pueden usarse para comprimir datos, aunque generalmente no superan a los algoritmos de compresión tradicionales.

- Representación de Características (Feature Learning): Los Autoencoders aprenden representaciones útiles de los datos que pueden utilizarse como entrada para otros modelos de aprendizaje automático.

Ejemplos Concretos:

- En la industria manufacturera, los Autoencoders se utilizan para detectar anomalías en los datos de los sensores de las máquinas, lo que permite predecir fallos y realizar el mantenimiento de forma proactiva.

- En el sector financiero, los Autoencoders se utilizan para detectar transacciones fraudulentas analizando los patrones de gasto de los clientes.

- En la medicina, los Autoencoders se utilizan para analizar imágenes médicas y detectar enfermedades en etapas tempranas.

En resumen, los Autoencoders son una herramienta poderosa y versátil para la reducción de dimensionalidad, la detección de anomalías y la generación de datos. Su capacidad para aprender representaciones comprimidas y significativas de los datos los convierte en una opción valiosa para una amplia gama de aplicaciones en diversas industrias. Con bibliotecas como Keras, la implementación y el entrenamiento de Autoencoders se han vuelto más accesibles que nunca, permitiendo a los científicos de datos y a los ingenieros explorar y aprovechar su potencial en sus proyectos.