Dominando Apache Spark (I): Introducción y ventajas en el procesamiento de grandes volúmenes de datos

¡Bienvenido a la serie de artículos Dominando Apache Spark! Esta colección está diseñada para llevarte a través de un emocionante viaje de aprendizaje sobre Apache Spark y su aplicación en el procesamiento de grandes volúmenes de datos. En esta colección aprenderemos, entre otras cosas, los siquientes apartados:

- Introducción a Apache Spark

- Arquitectura de Spark

- Entorno de Databricks

- PySpark: Apache Spark para Python

- Analítica Avanzada y Visualización de Datos con Databricks

- Machine Learning con Spark en Databricks

- Spark Streaming en Databricks

Este es el primer artículo de la serie, y en él, exploraremos los fundamentos de Apache Spark.

El procesamiento de grandes volúmenes de datos es una tarea esencial en la era digital. Empresas, instituciones de investigación y organizaciones de todo tipo generan enormes cantidades de datos a diario. Para extraer valor de estos datos y tomar decisiones informadas, se requiere una infraestructura de procesamiento de datos escalable y eficiente. Como hemos mencionado, en este artículo, te introduciremos a Apache Spark, una de las herramientas más poderosas en el procesamiento de grandes volúmenes de datos.

¿Qué es Apache Spark?

Apache Spark es un marco de procesamiento de datos de código abierto que se ha convertido en un estándar en la industria para el procesamiento de grandes volúmenes de datos. Desarrollado en la Universidad de California, Berkeley, Spark es una solución altamente eficiente y versátil que aborda los desafíos de procesamiento y análisis de datos a gran escala.

A diferencia de las soluciones anteriores, Spark proporciona un rendimiento excepcional y una API amigable para el usuario, lo que lo hace ideal para tareas que van desde la exploración de datos hasta la construcción de modelos de aprendizaje automático.

Entre los diversos casos de uso que tiene Spark, se encuentran los siguientes:

- Análisis de Datos en Tiempo Real: Empresas que requieren análisis en tiempo real, como las redes sociales, utilizan Spark para analizar flujos de datos continuos.

- Procesamiento de Lotes: Spark es ideal para tareas de procesamiento de lotes, como la preparación de datos y el análisis de registros masivos.

- Aprendizaje Automático: MLlib, la biblioteca de aprendizaje automático de Spark, permite la construcción de modelos de forma eficiente.

- Procesamiento de Gráficos: Spark es esencial para aplicaciones que implican análisis de redes sociales y relaciones de datos.

- Exploración y Visualización de Datos: Las herramientas de análisis y visualización se benefician del rendimiento de Spark al explorar datos a gran escala.

La innovación clave que distingue a Apache Spark es su enfoque en el procesamiento en memoria. A diferencia de enfoques anteriores que dependían en gran medida de la lectura y escritura en disco, Spark utiliza un modelo de almacenamiento en memoria distribuido. Esto significa que los datos se mantienen en la memoria RAM y se procesan en paralelo, lo que proporciona un rendimiento excepcional y una capacidad de escalabilidad lineal. Esta estrategia es imprescindible para aplicaciones que requieren análisis en tiempo real y el procesamiento de grandes conjuntos de datos.

Orígenes en la Universidad de California, Berkeley

Apache Spark tuvo sus raíces en la Universidad de California, Berkeley, donde se concibió como una respuesta a las limitaciones percibidas de las soluciones de procesamiento de datos existentes. Desde su concepción en 2009, el proyecto ha experimentado un crecimiento meteórico y se ha convertido en un pilar de la industria. Su diseño modular y su capacidad de integración con otros componentes del ecosistema de big data lo hacen altamente versátil y adaptable a una variedad de aplicaciones y entornos.

En la era del big data, Apache Spark se ha convertido en una herramienta esencial para organizaciones que buscan aprovechar sus recursos de datos al máximo. Su capacidad para procesar grandes volúmenes de datos en memoria y ejecutar operaciones en paralelo lo hace indispensable para aplicaciones de análisis en tiempo real y proyectos de aprendizaje automático. Además, su compatibilidad con varios lenguajes de programación, como Scala, Python y Java, lo convierte en una opción atractiva para una amplia gama de profesionales técnicos, científicos de datos y desarrolladores.

¿Por qué Apache Spark?

La elección de Apache Spark para el procesamiento de grandes volúmenes de datos se justifica por varias razones clave:

Ventaja 1: Procesamiento en memoria

Como hemos mencionado anteriormente, una de las características distintivas de Apache Spark es su enfoque en el procesamiento en memoria. Spark almacena los datos en memoria RAM y permite el procesamiento en paralelo. Esto se traduce en una velocidad de procesamiento significativamente mayor en comparación con las soluciones que dependen de la lectura y escritura en disco.

La capacidad de mantener los datos en memoria acelera el acceso a la información, lo que es esencial para aplicaciones de análisis en tiempo real y proyectos de aprendizaje automático.

RDD (Resilient Distributed Dataset) es el corazón de Spark. Es una colección distribuida de datos que puede ser procesada en paralelo. RDD es inmutable y tolerante a fallos, lo que significa que, incluso en caso de fallas en los nodos, los datos se pueden recuperar y la computación continúa sin problemas.

Además, Spark permite trabajar con datos estructurados (DataFrames), datos semiestructurados y no estructurados.

Ventaja 2: Rendimiento sobresaliente

La eficiencia y el rendimiento sobresaliente son características clave de Apache Spark. Al reducir la necesidad de acceder a datos en disco, Spark supera los cuellos de botella y permite un procesamiento rápido y eficiente. Esto revoluciona la velocidad de procesamiento y hace que Spark sea una opción ideal para aplicaciones que requieren respuestas rápidas a los datos entrantes.

Ventaja 3: Flexibilidad en lenguajes de programación

Apache Spark aborda la limitación de la compatibilidad con lenguajes de programación al ofrecer soporte para múltiples idiomas. Los desarrolladores pueden escribir código Spark en lenguajes como Scala, Python y Java, lo que facilita su adopción y adaptación a diversas habilidades y preferencias.

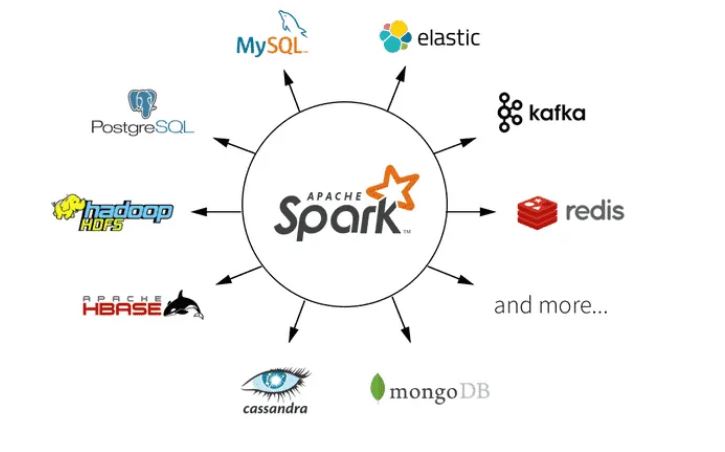

Ventaja 4: Integración y ecosistema

La plataforma Spark no solo proporciona una base sólida, sino que también se integra con un rico ecosistema de bibliotecas y herramientas. Spark SQL, Spark Streaming, MLlib y GraphX son ejemplos de extensiones y bibliotecas que enriquecen su funcionalidad y lo hacen adecuado para una variedad de aplicaciones, desde análisis de datos hasta procesamiento de gráficos y aprendizaje automático.

Iniciando con Databricks Community

La instalación de Apache Spark en un entorno local o en un clúster puede ser un proceso dificil especialmente para quienes se están iniciando en el mundo de Spark, por lo que le dedicaremos un artículo posteriormente. Por suerte, existe una alternativa sencilla y gratuita que simplifica enormemente este proceso y permite un inicio rápido en el aprendizaje de Spark, que consiste en aprovechar la versión Community de Databricks.

Tan solo requiere registrarse y, en un abrir y cerrar de ojos, tendrás acceso a un entorno de fácil manejo que te permitirá escribir código en Scala, Python, R y SQL. Lo mejor de todo es que podrás utilizar los cuadernos (notebooks) que esta plataforma ofrece de manera completamente gratuita.

Databricks una plataforma basada en Spark que simplifica muchas de las tareas de instalación y configuración. Además, ofrece una interfaz en la nube que permite a los usuarios centrarse en la creación de aplicaciones y análisis de datos en lugar de preocuparse por la administración de infraestructura, ¡Por lo que te vendrá de perlas para comenzar a aprender!

En este primer artículo de nuestra serie «Dominando Apache Spark», hemos explorado los conceptos fundamentales detrás de esta poderosa herramienta de procesamiento de datos. Hemos comprendido por qué Apache Spark ha revolucionado el mundo del big data, su enfoque innovador en el procesamiento en memoria y su versatilidad.

En el siguiente artículo de la serie, nos sumergiremos en los aspectos técnicos y prácticos de Apache Spark. Exploraremos en detalle su funcionamiento interno y su arquitectura, lo que nos permitirá comprender cómo esta plataforma aborda los desafíos de procesamiento de grandes volúmenes de datos. ¡Hasta la próxima entrega!